Cluster Faraday

El Clúster Faraday, iniciativa creada y promovida por un grupo interdisciplinario de investigadores del Programa Institucional de Fomento a la Investigación, Desarrollo e Innovación (PIDi) de Universidad Tecnológica Metropolitana (UTEM), forma parte del equipamiento de la Red de Laboratorios de Investigación de la institución la que, entre otros fines, permite estimular sinergias entre investigadoras/es y líneas de investigación en la Universidad, facilitando las interacciones internas y con grupos de investigación de otras instituciones nacionales e internacionales.

El Clúster Faraday fue financiado por el Proyecto FONDEQUIP EQM180180 “Clúster Supermicro para Cómputo Científico”, y es recurso clave de la infraestructura computacional; la infraestructura se ubica en el Datacenter del Edificio de Ciencia y Tecnología (ECT) de la UTEM (Ignacio Valdivieso 2409, San Joaquín, Santiago). El clúster apoya investigaciones de la comunidad académica de la Universidad, así como de investigadoras e investigadores de otras instituciones de Chile y el mundo. También apoya el desarrollo de tesis de pregrado y postgrado. El equipo cuenta con 824 núcleos de cómputo, 3.2 TB RAM y 72 TB de almacenamiento masivo.

Proyecto Financiado por:

Fondequip

Fondo de Equipamiento Científico y Tecnológico

VII Concurso de Equipamiento Científico y Tecnológico Mediano FONDEQUIP

Proyecto EQM180180

Equipo Responsable

Diego Cortés Arriagada

Coordinador Responsable

Doctor en Química

Osvaldo Delgado González

Administrador

Candidato a Doctor en Informática Aplicada a Salud y Medio Ambiente

http://www.onyxtech.cl/

Soporte Técnico y Mantención

The Cluster Faraday is an initiative promoted by an interdisciplinary group of researchers at the Universidad Tecnológica Metropolitana (UTEM), and financed by the FONDEQUIP Project, EQM180180. “Supermicro Cluster for Scientific Computing.” This computational cluster supports research projects, undergraduate student theses, and teaching activities at the UTEM Ph.D. program (Doctorado en Ciencias de Materiales e Ingeniería de Procesos).

Políticas de Acceso y Uso

Antes de utilizar el equipamiento, tenga en consideración las siguientes Políticas de Acceso y Uso del equipamiento.

Agradecimientos

El Clúster Faraday entrega recursos computacionales de forma gratuita a todos sus usuarios, y su funcionamiento está financiado de forma limitada por ANID – FONDEQUIP EQM180180 y la Universidad Tecnológica Metropolitana. Por lo tanto, los usuarios de la infraestructura asumen que todo el producto científico realizado en el clúster debe ser reconocido como se establece a continuación.

En español: “Investigación/tesis apoyada por el Clúster Faraday UTEM (ANID FONDEQUIP EQM180180)”.

En inglés: “This research/thesis was supported by the Cluster Faraday UTEM (ANID FONDEQUIP EQM180180)”.

Este reconocimiento debe estar explícito en toda publicación de cualquier material que se base total o parcialmente en el uso del clúster, lo que incluye tesis/ memorias de título, publicación científica, presentación oral o póster en congresos y simposios y presentaciones de divulgación científica.

Para consultas, escribir a: clusterfaraday.idt@utem.cl

Solicitud/Renovación de Acceso

Renovación de Acceso

Todas las cuentas estarán sujetas a renovación en Diciembre del año en curso. La renovación de la cuenta tiene la calidad de “información relevante” para consideración del usuario. En el caso de cuentas de grupo creadas por “un usuario ya existente en la infraestructura”, podrá ser este último el encargado de la renovación, indicando todas las cuentas de usuarios asociadas a dicha renovación. La renovación de cuenta incluye la evaluación de la productividad científica y el uso adecuado de los recursos empleados.

Nuevo Usuario

Para solicitar acceso al clúster, pinchar en el icono y rellenar el formulario siguiendo las instrucciones que allí se indiquen. Luego de recibir y revisar toda la información, el equipo de soporte se comunicara para indicarle los pasos a seguir.

Solicitudes cerradas.

Nuevo Usuario de un Grupo de Investigación

Tesistas, becarios, asistentes de investigación, personal técnico, y/u otros asociados a proyectos de investigación de “un usuario ya existente en la infraestructura” [sea este un académico(a) y/o investigador(a) interno(a) o externo(a) a la Universidad Tecnológica Metropolitana], sus cuentas podrán ser abiertas en cualquier periodo del año y solo por el usuario ya existente en la infraestructura a través del presente registro.

Tutoriales y Scripts

Acceso al Cluster via WinSCP y Putty

Tutorial de conexión remota al SCC usando los programas Winscp y Putty (versión Windows ).

Acceso: Tutorial Winscp y Putty

Gestor Slurm Para la Ejecución de Trabajos

La gestión y ejecución de tareas en el clúster se hacen mediante el gestor de colas Slurm. Este gestor tiene tres funciones clave. Primero, asigna acceso exclusivo y / o no exclusivo a los recursos (nodos de cómputo) a los usuarios durante un período de tiempo para que puedan realizar el trabajo. En segundo lugar, proporciona un marco para iniciar, ejecutar y supervisar el trabajo (normalmente un trabajo en paralelo) en el conjunto de nodos asignados. Finalmente, gestiona los recursos administrando una cola de trabajo pendiente.

En el siguiente enlace, se encuentra una guía de uso rápida del gestor Slurm (https://slurm.schedmd.com/quickstart.html), la cual es fundamental para la ejecución de trabajos en la infraestructura.

Tutorial Gaussian16/09

Tutorial de uso básico y ejecución de tareas de Gaussian16/09. Nótese que Gaussian16/09 está restringido a usuarios que posean una licencia comercial validada.

Acceso: Tutorial Gaussian16/09

Scripts

Acá se describen scripts desarrollados para facilitar la ejecución de ciertos programas. Para todos los scripts, considerar:

Partición para calcular en SCC, opción q=queue, donde queue es:

intel : 32 Procs, 128GB RAM (12 Nodos).

sm : 128 Procs, 370GB RAM (1 Nodo).

gpu : 40 Procs, 370GB RAM (1 Nodo, 4 GPUs).

amd : 16 Procs, 16 GB RAM (1 Nodo).

Gaussian16/09

Uso: qG16 [options] <Archivo de input> <Archivo Output> <Nombre del proceso>

Uso: qG09 [options] <Archivo de input> <Archivo Output> <Nombre del proceso>

Options:

-h, –help show this help message and exit

-q QUEUE Cola de destino

–extencion=EXTENCION

extenciones a copiar

–parametros=PARAMETROS

Parámetros adicionales (Se ingresan entre comillas)

Carga de utilitarios Gaussian16/09: Para cargar los subprogramas de Gaussian 16/09, ej, cubegen, formchk, unfchk, etc, indicar la ruta completa del ejecutable, junto al nombre del ejecutable.

Ej: Formchk

/opt/g16/formchk

/opt/g09/formchk

Ej: Cubegen

/opt/g16/cubegen

/opt/g09/cubegen

ORCA 4.1.2/4.2.1/5.0.0

Uso: qOrca [options] <Nombre del proceso> <Archivo de input>

Options:

-h, –help show this help message and exit

-o OUTPUTFILE Archivo de Output

-q QUEUE Cola de destino

-m MEM Memoria a reservar

-c NPROC Procesadores por nodo

-v VERSION Version de orca a usar

–parametros=PARAMETROS

Parámetros adicionales (Se ingresan entre comillas)

Versiones pueden ser:

4_0_1_linux_x86-64_openmpi202

4_1_2_linux_x86-64_openmpi313

4_2_1_linux_x86-64_openmpi314

5_0_0_linux_x86-64_openmpi411

Carga de utilitarios ORCA: Para cargar los subprogramas de ORCA, ej, orca_plot, orca_2mkl, etc, indicar la ruta completa del ejecutable, junto al nombre del ejecutable que sea compatible con la version usada en el calculo.

Ej: orca_2mkl

/opt/orca_4_1_2_linux_x86-64_openmpi313/orca_2mkl

Ej: orca_plot

/opt/orca_4_1_2_linux_x86-64_openmpi313/orca_plot

NAMD

Uso: qNamd [options] <Nombre del proceso> <Archivo de input>

Options:

-h, –help show this help message and exit

-o OUTPUTFILE Archivo de Output (default=output.log)

-q QUEUE Cola de destino

-g GPU Numero de GPUs

-m MEM Memoria a reservar

-n NODOS Nodos (Default=1)

-c NPROC Procesadores por nodo (Default=8)

-v VERSION Version a usar

–parametros=PARAMETROS

Parámetros adicionales (Se ingresan entre comillas)

OCTOPUS

Uso: qOctopus [options] <Nombre del proceso>

Options:

-h, –help show this help message and exit

-o OUTPUTFILE Archivo de Output

-q QUEUE Cola de destino

-m MEM Memoria a reservar

-c NPROC Procesadores por nodo

-v VERSION Version de orca a usar

–parametros=PARAMETROS

Parámetros adicionales (Se ingresan entre comillas).

Q-Chem 5.2.2

Uso: qQChem [options] <Nombre del proceso> <Archivo de input>

Options:

-h, –help show this help message and exit

-o OUTPUTFILE Archivo de Output

-q QUEUE Cola de destino

-m MEM Memoria a reservar

-n NODOS Nodos

-c NPROC Procesadores por nodo (Defecto = 4)

–parametros=PARAMETROS

Parámetros adicionales (Se ingresan entre comillas)

ChemShell

Uso: qChemsh [options] <Nombre del proceso> <Archivo de input>

Options:

-h, –help show this help message and exit

-o OUTPUTFILE Archivo de Output

-q QUEUE Cola de destino

-m MEM Memoria a reservar

-c NPROC Procesadores por nodo

-v VERSION Version de chemsh a usar

–turbomole Usa Turbomole

–orca Usa Orca

–parametros=PARAMETROS

Parámetros adicionales (Se ingresan entre comillas)

Turbomole

Uso : qTurbomole [options] <Nombre del proceso>

Options:

-h, –help show this help message and exit

-o OUTPUTFILE Archivo de Output

-q QUEUE Cola de destino

-m MEM Memoria a reservar

-c NPROC Procesadores por nodo

-v VERSION Version a usar

–runfile=RUNFILE Elementos para ejecutar turbomole

–parametros=PARAMETROS

Parámetros adicionales (Se ingresan entre comillas)

Multiwfn

Uso: qMultiwfn [options] <Nombre del proceso>

Options:

-h, –help show this help message and exit

-o OUTPUTFILE Archivo de Output

-q QUEUE Cola de destino

-m MEM Memoria a reservar

-c NPROC Procesadores por nodo (Se considerara el de

setting.ini si es que esta)

-v VERSION Version de orca a usar

–parametros=PARAMETROS

Parámetros adicionales (Se ingresan entre comillas)

Ayuda

Trabajos Cancelados

Todos los trabajos serán cancelados al exceder el tiempo limite de cómputo sin excepción. Si su trabajo necesita más tiempo para terminar, puede reiniciarlo a partir de los archivos de recuperación del programa que este usando.

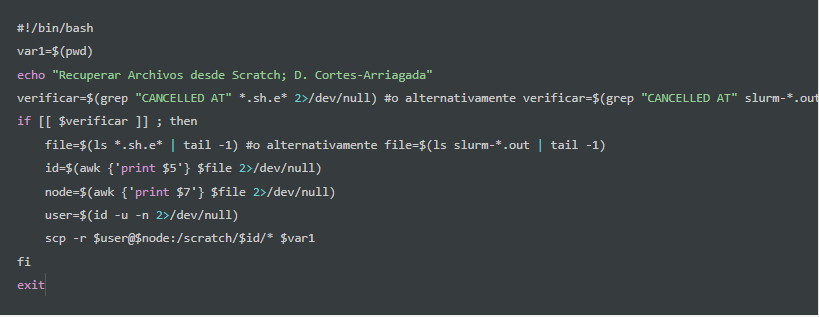

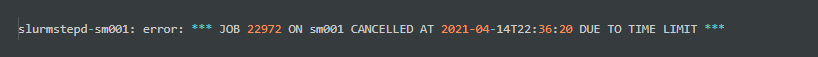

Algunos programas como Gaussian y ORCA harán las tareas de cómputo en una carpeta denominada ‘scratch‘ ubicada en el nodo en el cual se desarrolla el trabajo. Si fuese necesario recuperar trabajos o archivos temporales de un trabajo cancelado, puede recuperar esos trabajos desde el directorio ‘scratch’. Para ello debe revisar el archivo de error *.sh.e* o slurm-*.out, el cual contendrá el ID del trabajo cancelado y el nodo en cual se ejecutó hasta ser cancelado:

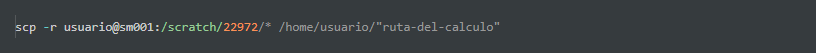

Este trabajo tiene el ID 22972 y se ejecuto en el nodo sm001. Con estos datos se puede recuperar los archivos temporales disponibles a la carpeta del usuario mediante:

Alternativamente, puede utilizar el siguiente script para recuperar directamente los archivos desde el scratch: